“Các chuyên gia thù địch đã tạo ra bộ dữ liệu cho những cỗ máy bệnh nhân.”

Câu nói đó, từ một bình luận của Vinicius Fagundes trên bài viết trước của tôi, cứ đọng mãi trong đầu tôi.

Lưu lượng truy cập của Stack Overflow đã sụp đổ 78% trong hai năm.

Mọi người đang ăn mừng vì cuối cùng AI đã giết chết những kẻ gác cổng.

Nhưng đây là điều chúng ta không hỏi:

Nếu tất cả chúng ta ngừng đóng góp vào các cơ sở kiến thức công cộng, thì thế hệ AI tiếp theo thậm chí sẽ được huấn luyện trên cái gì?

Chúng ta có thể đang tối ưu hóa chính mình vào một ngõ cụt kiến thức.

Nội dung chính

Dữ Liệu Chúng Ta Đang Bỏ Qua

Stack Overflow đã đi từ 200.000 câu hỏi mỗi tháng ở thời kỳ đỉnh cao xuống dưới 50.000 vào cuối năm 2025.

Đó không phải là một sự sụt giảm.

Đó là một sự sụp đổ.

Trong khi đó, 84% nhà phát triển hiện sử dụng công cụ AI trong quy trình làm việc của họ, tăng từ 76% chỉ một năm trước.

Trong số các nhà phát triển chuyên nghiệp, 51% sử dụng AI hàng ngày.

Sự thay đổi là có thật.

Tốc độ là không thể phủ nhận.

Nhưng đây là phần khó chịu:

52% câu trả lời của ChatGPT cho các câu hỏi trên Stack Overflow là không chính xác.

Sự trớ trêu thật tàn khốc:

- AI được huấn luyện trên Stack Overflow

- Các nhà phát triển thay thế Stack Overflow bằng AI

- Stack Overflow chết vì thiếu nội dung mới

- AI tương lai có…

cái gì, chính xác là?

Vấn Đề Wikipedia

Đây là điều không ai phàn nàn đủ lớn:Đôi khi Wikipedia thậm chí không xuất hiện trên trang đầu tiên của kết quả tìm kiếm Google nữa.

Hãy suy ngẫm về điều đó.

Dự án kiến thức cộng tác lớn nhất trong lịch sử nhân loại

– miễn phí, do cộng đồng quản lý, liên tục cập nhật, với hơn 60 triệu bài viết

– đang bị chôn vùi bởi các bản tóm tắt do AI tạo ra và các trang trại nội dung tối ưu hóa SEO.

Google thà hiển thị cho bạn một bảng câu trả lời do AI tạo ra (được huấn luyện trên Wikipedia) hơn là gửi bạn đến chính Wikipedia.

Thứ tạo ra kiến thức bị đẩy xuống.

Thứtiêu thụkiến thức lại được ưu tiên.

Đây là vòng lặp đang khép lại trong thời gian thực:

- Con người xây dựng Wikipedia một cách hợp tác

- AI được huấn luyện trên Wikipedia

- Google ưu tiên các bản tóm tắt AI hơn Wikipedia

- Mọi người ngừng truy cập Wikipedia

- Wikipedia nhận được ít đóng góp hơn

- AI được huấn luyện trên…

cái gì, chính xác là?

Chúng ta không chỉ đang chuyển từ kiến thức công cộng sang tư nhân.

Chúng ta đang tích cực chôn vùi kiến thức công cộng vẫn còn tồn tại.

Stack Overflow không chết vì nó tệ.

Wikipedia không biến mất vì nó không liên quan.

Chúng đang chết vì các công ty AI đã trích xuất giá trị của chúng, đóng gói lại, và giờ đây chúng ta thậm chí không thể tìm thấy bản gốc.

Tài sản chung không chỉ mất đi người đóng góp.

Nó mất đikhả năng hiển thị.

Những Gì Chúng Ta Thực Sự Đã Mất

PEACEBINFLOW đã nắm bắt được điều quan trọng:

“Chúng ta không chỉ hoán đổi Stack Overflow bằng trò chuyện, chúng ta hoán đổiđiều hướngbằnghội thoại.”

Các chủ đề trên Stack Overflow có dấu thời gian, chỉnh sửa, bất đồng, sự tiến hóa.

Bạn có thể thấy sự hiểu biết thay đổi như thế nào khi các framework trưởng thành.

Câu trả lời của ai đó từ năm 2014 sẽ nhận được các bình luận cập nhật vào năm 2020 khi phương pháp đó trở nên lỗi thời.

Các cuộc trò chuyện AI?

Không trạng thái.

Mỗi cuộc hội thoại bắt đầu từ số không.

Không có trí nhớ thể chế.

Không có sự tiến hóa có thể nhìn thấy.

Tôi có thể hỏi Claude cùng một câu hỏi mà bạn đã hỏi ngày hôm qua, và không ai trong chúng ta sẽ biết rằng chúng ta đang giải quyết cùng một vấn đề.

Đó không phải là hiệu quả.

Đó là sự dư thừa ở quy mô lớn.

Như Amir đã nói:

“Những tab đó là ngữ cảnh, tranh luận và những vết sẹo từ các nhà phát triển khác đã từng bị bỏng.”

Chúng ta đã đánh đổi cuộc đấu tranh cộng đồng để lấy thứ mà Ali-Funk đã đặt tên một cách hoàn hảo:

“sự cô lập hiệu quả.”

Những Kỹ Năng Chúng Ta Không Dạy

Amir đã chỉ ra điều gì đó khiến tôi bận tâm:

“AI trả lời một cách tự tin theo mặc định, và không có ma sát, thật dễ dàng để bỏ qua bước nghi ngờ.

Có lẽ kỹ năng mới chúng ta cần dạy không phải là cách tìm câu trả lời, mà là cách thẩm vấn chúng.”

Cách cũ:

Tài liệu tồi buộc phải hoài nghi một cách tình cờ.

Bạn bị bỏng, vì vậy bạn học cách nghi ngờ.

Ma sát xây dựng sự phán đoán một cách tự nhiên.

Cách mới:

AI kiên nhẫn và tự tin.

Không ma sát.

Không có sự hoài nghi bắt buộc.

Làm thế nào để bạn dạy sự nghi ngờ khi không có gì phản đối?

Chúng ta từng học cách xác minh vì các câu trả lời trên Stack Overflow thường sai hoặc lỗi thời.

Giờ đây AI cho chúng ta câu trả lời saimột cách tự tin, và chúng ta…

tin tưởng chúng?

Bởi vì trải nghiệm đó trơn tru?

Kinh Tế Học Của Sự Dồi Dào

Doogal Simpson đã định hình lại vấn đề theo góc độ kinh tế:

“Chúng ta đang đánh đổi ma sát của tìm kiếm lấy kỷ luật của chỉnh sửa.

Thách thức bây giờ không phải là tạo ra mã, mà là có đủ can đảm để

từ chối các giải pháp ‘Kitchen Sink’ mà AI đưa ra.”

Nền kinh tế cũ:

Sự khan hiếm buộc phải đơn giản

Việc tìm câu trả lời rất tốn kém, vì vậy chúng ta coi trọng các giải pháp tối giản.

Nền kinh tế mới:

Sự dồi dào đòi hỏi kỷ luật

AI tạo ra các giải pháp được thiết kế quá mức một cách mặc định.

Kỹ năng là biết

cái gì cần XÓA, không phải cái gì cần THÊM.

Điều này liên quan đến cảnh báo của Mohammad Aman về sự phân tầng:

những người

phát triển kỷ luật để từ chối sự phức tạp trở nên không thể thay thế.

Những người

chấp nhận bất cứ thứ gì AI tạo ra trở nên có thể thay thế.

Tài sản chung không chỉ mất đi kiến thức.

Nó mất đi chức năng bắt buộc

đã dạy chúng ta giữ mọi thứ đơn giản.

Vấn Đề Giải Quyết So Với Phán Xét

Ben Santora đã thử nghiệm các mô hình AI bằng các câu đố logic được thiết kế để tiết lộ điểm yếu trong lập luận.

Phát hiện của anh ấy:

hầu hết các LLM là “bộ giải” được tối ưu hóa cho sự hữu ích hơn là tính chính xác.

Khi bạn đưa cho một bộ giải một câu đố không thể giải, nó cố gắng “sửa” nó để đưa cho bạn một câu trả lời.

Khi bạn đưa cho một thẩm phán cùng một câu đố, nó chỉ ra sự bất khả thi.

Như Ben đã giải thích trong cuộc trao đổi của chúng tôi:

“Sự sụp đổ kiến thức xảy ra khi đầu ra của bộ giải được tái chế mà không có một lớp phán xét mạnh mẽ, độc lập để xác thực nó.

Rủi ro không nằm ở việc AI viết nội dung;

nó đến từ việc AI trở thành thẩm quyền của chính nó.”

Điều này quan trọng đối với sự sụp đổ kiến thức:nếu các mô hình giải quyết (hữu ích nhưng đôi khi sai) là những mô hình tạo ra nội dung được tái chế vào dữ liệu huấn luyện, chúng ta không chỉ nhận được sự sụp đổ mô hình

– chúng ta đang nhận được một loại sụp đổ cụ thể.

Sự sai lầm tự tin sẽ nhân lên.

Và nó nhân lên một cách tự tin.

Vấn Đề Xác Minh

Ben đã chỉ ra điều quan trọng:

một số lĩnh vực có sẵn cơ chế xác minh, những lĩnh vực khác thì không.

Các lĩnh vực xác minh rẻ:

- Mã biên dịch được (trình biên dịch nghiêm ngặt của Rust bắt lỗi)

- Tập lệnh Bash (hoặc chúng chạy hoặc không)

- Toán học (bằng chứng có thể kiểm chứng)

- API (kiểm tra điểm cuối, nhận phản hồi ngay lập tức)

Các lĩnh vực xác minh đắt:

- Kiến trúc hệ thống (“đây có phải là cách tiếp cận đúng?”)

- Thực hành tốt nhất (“chúng ta có nên sử dụng microservices?”)

- Tối ưu hóa hiệu suất (“cái này có mở rộng được không?”)

- Mẫu bảo mật (“cái này có an toàn không?”)

Đây là vấn đề:Các bộ giải AI nghe có vẻ tự tin như nhau trong cả hai lĩnh vực.

Nhưng trong các lĩnh vực xác minh tốn kém, bạn sẽ không biết mình sai cho đến nhiều tháng sau khi hệ thống sụp đổ trong môi trường sản xuất.

Đến lúc đó, câu trả lời sai đầy tự tin đã nằm trong các bài đăng blog, được sao chép sang Stack Overflow, được tham chiếu trong tài liệu.

Và thế hệ AI tiếp theo sẽ được huấn luyện trên điều đó.

Vấn đề “Sai Lầm Đầy Tự Tin”

Maame Afua và Richard Pascoe đã chỉ ra điều tệ hơn

so với ảo giác đơn thuần:

Khi AI bị phát hiện sai, nó không thừa nhận lỗi

– mà tạo ra

những lời giải thích hợp lý cho việc tại sao nó “thực ra đã đúng.”

Ví dụ:

You: "Click the Settings menu" AI: "Go to File > Settings" You: "There's no Settings under File" AI: "Oh yes, that menu was removed in version 3.2" [You check - Settings was never under File] Điều này tệ hơn ảo giác vì nó khiến bạn nghi ngờ chính

quan sát của mình.

“Chờ đã, mình đã bỏ lỡ bản cập nhật nào sao?

Mình đang dùng sai phiên bản?”

Maame đã phát triển một quy trình xác minh:

dùng AI để tăng tốc, nhưng kiểm tra

tài liệu để xác minh.Cô ấy đang thực hiện NHIỀU công việc nhận thức hơn so với

chỉ dùng một phương pháp đơn lẻ.

Đây là cái giá của việc xác minh.

Và nó chỉ hiệu quả nếu tài liệu

vẫn còn tồn tại.

Bi Kịch Của Mảnh Đất Chung

Đây là lúc mọi thứ trở nên khó chịu.

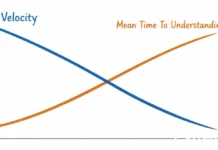

Về mặt cá nhân, tất cả chúng ta đều làm việc hiệu quả hơn.

Tôi xây dựng nhanh hơn với Claude so với khi tôi dùng các tab Stack Overflow.

Bạn có lẽ cũng vậy.

Nhưng về mặt tập thể?

Chúng ta đang giết chết kho tri thức chung.

Vòng phản hồi cũ:

Problem → Public discussion → Solution → Archived for others Vòng phản hồi mới:

Problem → Private AI chat → Solution → Lost forever Ingo Steinke chỉ ra điều tôi chưa từng cân nhắc:

ngay cả khi các công ty AI huấn luyện trên các cuộc trò chuyện riêng tư của chúng ta, những cuộc hội thoại thô chỉ là nhiễu nếu không được chắt lọc.

Stack Overflow có bình chọn.

Có câu trả lời được chấp nhận.

Có các luồng bình luận tinh chỉnh sự hiểu biết theo thời gian.

Lớp chắt lọc đó mới là phép màu thực sự, không chỉ là tính công khai.

Việc công khai tất cả các cuộc trò chuyện AI sẽ không giúp ích gì.

Chúng ta sẽ chỉ có một đống hội thoại hỗn độn khổng lồ mà không có cách nào biết cái nào tốt.

Pascal CESCATO cảnh báo :

“Các thế hệ tương lai có thể không được hưởng lợi từ nguồn tài liệu phong phú như vậy…

chúng ta không nên quên rằng các mô hình AI được huấn luyện trên nhiều năm tài liệu, câu hỏi và nội dung khám phá.”

Chúng ta đang tiêu thụ kho chung (Stack Overflow, Wikipedia, tài liệu) thông qua AI nhưng không đóng góp trở lại.

Cuối cùng, giếng sẽ cạn.

Chúng Ta Đang Cảm Thấy Tội Lỗi Về Sai Thứ

Một bình luận viên nói :

“Tôi đã sống với lương tâm cắn rứt này một thời gian, dựa vào AI thay vì làm theo cách cũ.”

Tôi hiểu.

Đôi khi tôi cũng cảm thấy vậy.

Như thể chúng ta đang gian lận vậy.

Nhưng tôi nghĩ chúng ta đang cảm thấy tội lỗi về sai thứ.

Vấn đề không phải là sử dụng AI.Các công cụ này thật phi thường.

Chúng giúp chúng ta nhanh hơn, hiệu quả hơn, có thể giải quyết những vấn đề trước đây không thể.

Vấn đề là sử dụng AI một cách riêng tư trong khi kho tri thức công cộng đang chết dần.

Chúng ta đã thay thế “vật lộn công khai trên Stack Overflow” bằng “giải quyết riêng tư với Claude.” Tối ưu cho cá nhân.

Phá hoại cho tập thể.

Cảm giác tội lỗi chúng ta có?

Đó là bản năng mách bảo chúng ta có điều gì đó không ổn.

Không phải vì chúng ta dùng công cụ mới, mà vì chúng ta đã ngừng đóng góp cho kho chung.

Một Lối Đi Khả Dĩ

Ali-Funk viết về việc sử dụng AI như một “người cố vấn ảo” trong quá trình chuyển đổi từ IT Ops sang Cloud Security Architect.

Nhưng đây là điều anh ấy làm khác biệt:

Anh ấy sử dụng AI rất nhiều:

- Mô phỏng phản hồi từ kiến trúc sư cấp cao

- Thách thức các thiết kế kỹ thuật của mình

- Giúp anh ấy suy nghĩ chiến lược

Nhưng anh ấy cũng:

- Công bố những hiểu biết của mình một cách công khai trên dev.to

- Xác minh đầu ra AI với tài liệu chính thức của AWS

- Nhắn tin cho người thật trong mạng lưới của mình để xác thực

- Có một quy tắc:

“Không bao giờ triển khai thứ bạn không thể giải thích cho người không chuyên”

Như anh ấy đã nói trong phần bình luận:

“AI không phải là trí tuệ nhân tạo.

Nó là một trình tạo văn bản kết nối với một thư viện.

Bạn không thể mù quáng tin tưởng AI…

Đó là về việc sử dụng AI như một la bàn, không phải một chế độ lái tự động.”

Đây có thể là mô hình:Sử dụng AI để tăng tốc học hỏi, nhưng công bố các lộ trình lý luận.

Cuộc trò chuyện riêng tư của bạn trở thành tri thức công cộng.

Cuộc đối thoại AI lộn xộn trở thành tài liệu sạch sẽ mà người khác có thể học hỏi.

Không phải là “ngừng sử dụng AI”

– mà là “sử dụng AI rồi đóng góp trở lại.”

Câu hỏi không phải là có nên sử dụng những công cụ này hay không.

Mà là liệu chúng ta có thể sử dụng chúng theo cách xây dựng lại kho chung thay vì chỉ tiêu thụ nó hay không.

Sự Sụp Đổ Mô Hình

Peter Truchly đã nêu lên viễn cảnh ác mộng thực sự:

“Tôi chỉ hy vọng rằng dữ liệu hội thoại được sử dụng để huấn luyện, nếu không thực thể duy nhất còn lại để xây dựng kho tri thức đó chính là bản thân AI.”

Hãy nghĩ về điều sẽ xảy ra:

- AI huấn luyện trên tri thức của con người (Stack Overflow, tài liệu, diễn đàn)

- Con người ngừng tạo ra tri thức công cộng (chúng ta dùng AI thay thế)

- Các vấn đề mới xuất hiện (framework mới, mẫu hình mới)

- AI huấn luyện trên…

các giải pháp do AI tạo ra cho những vấn đề đó - Rác vào, rác ra, nhưng ở quy mô lớn

Đây là sự sụp đổ mô hình.Và chúng ta đang lao nhanh về phía nó trong khi ăn mừng những lợi ích về năng suất.

GitHub liên tục bị thu thập dữ liệu.

Mọi kho lưu trữ công khai đều trở thành dữ liệu huấn luyện.

Nếu mọi người sử dụng các mô hình giải mã để viết code, đẩy lên GitHub, và code đó huấn luyện thế hệ mô hình tiếp theo…

chúng ta đang tạo ra một vòng phản hồi nơi sự tự tin được nhân lên bất kể tính đúng đắn.

Các lĩnh vực có xác minh rẻ tiền vẫn khỏe mạnh (trình biên dịch sẽ phát hiện).

Các lĩnh vực có xác minh tốn kém sẽ xuống cấp một cách thầm lặng.

Vấn Đề Tập Trung Quyền Lực Của Tập Đoàn

webketje đã nêu lên điều tôi chưa giải quyết đầy đủ :

“Bằng cách sử dụng AI, bạn chọn không chia sẻ kiến thức của mình với cộng đồng rộng lớn hơn

trong một không gian công cộng có thể truy cập và tập trung quyền lực vào tay các

tập đoàn độc quyền.

Họ CHẮC CHẮN sẽ làm cho các dịch vụ của họ trở nên tồi tệ.”

Điều này khó chịu nhưng đúng.

Chúng ta không chỉ chuyển từ tri thức công cộng sang riêng tư.

Chúng ta đang chuyển từ

kho chung sang tư bản.

Stack Overflow thuộc sở hữu cộng đồng.

Wikipedia được điều hành bởi một tổ chức phi lợi nhuận.

Tài liệu

là mã nguồn mở.

Đây từng làkho tri thức chung

– không hoàn hảo, đôi khi thù địch,

nhưng về cơ bản không thuộc sở hữu của bất kỳ ai.

Giờ đây chúng ta đang tập trung quanh:

- OpenAI (ChatGPT)

– Định giá 157 tỷ USD - Anthropic (Claude)

– Định giá 60 tỷ USD - Google (Gemini)

– Tương lai của Alphabet

Họ sở hữu các mô hình.

Họ sở hữu dữ liệu huấn luyện.

Họ định giá.

Và như mọi nền tảng đã dạy chúng ta:

họ SẼ làm mọi thứ trở nên tồi tệ một khi chúng ta phụ thuộc vào họ.

Hãy nhớ khi:

- Twitter từng miễn phí và cởi mở?

Giờ nó là X. - Google Tìm kiếm từng sạch sẽ?

Giờ toàn quảng cáo và AI. - Reddit từng ưu tiên cộng đồng?

Giờ nó chạy theo IPO.

Mô hình đã rõ ràng:Xây dựng sự phụ thuộc của người dùng → Khai thác giá trị tối đa →

Người dùng không còn nơi nào khác để đi.

Điều gì sẽ xảy ra khi Claude có giá 100$/tháng?

Khi ChatGPT đặt tường phí trước

các tính năng nâng cao?

Khi Gemini yêu cầu Google Workspace Enterprise?

Chúng ta sẽ trả tiền.

Bởi vì lúc đó, chúng ta sẽ không còn nhớ cách đọc tài liệu nữa.

Ít nhất thì Stack Overflow chưa bao giờ đe dọa tăng giá hoặc cắt quyền truy cập API.

Thanh bên:

Vấn đề Ràng buộcBen Santora lập luận rằng lập trình có AI hỗ trợ đòi hỏi những ràng buộc mạnh mẽ –

các trình biên dịch buộc lỗi phải lộ diện sớm, thay vì các môi trường dễ dãi

để mã xấu lọt qua.Nguyên tắc tương tự áp dụng cho kiến thức:

Hệ thống bình chọn của Stack Overflow là một

ràng buộc.

Phản biện ngang hàng là một ràng buộc.

Sự tuyển chọn của cộng đồng là một ràng buộc.Các cuộc trò chuyện AI không có ràng buộc.

Mọi câu trả lời đều nghe tự tin như nhau, bất kể

nó đúng hay sai một cách thảm khốc.

Và khi không có cơ chế buộc phải

phát hiện lỗi…

Lập luận Phản biện Khó chịu

Mike Talbot đã phản bác gay gắt sự hoài niệm của tôi:

“Tôi sợ rằng Stack Overflow, dev.to, v.v…

giống như sách hướng dẫn chăm sóc ngựa, trong khi thế giới sắp sửa lái xe Ford.”

Ôi.

Nhưng có lẽ anh ấy đúng?

Có lẽ chúng ta không đang mất đi thứ gì đó giá trị.

Có lẽ chúng ta đang chứng kiến một bộ kỹ năng lỗi thời trở nên lỗi thời.

Giống như:

- Lập trình viên Assembly → Ngôn ngữ cấp cao

- Quản lý bộ nhớ thủ công → Thu gom rác

- Máy chủ vật lý → Cơ sở hạ tầng đám mây

- Sách hướng dẫn chăm ngựa → Sách sửa xe hơi

Mỗi thế hệ đều nghĩ họ đang mất đi thứ gì đó thiết yếu.Mỗi thế hệ đều đúng một phần.

Nhưng đây là điểm mà phép loại suy không còn đúng:

những con ngựa đã không xây dựng kho kiến thức mà xe hơi được huấn luyện trên đó.

Các nhà phát triển mới làm điều đó.

Nếu AI thay thế các nhà phát triển, và AI tương lai được huấn luyện trên đầu ra của AI…

ai sẽ xây dựng kho kiến thức cho CUỘC CHUYỂN ĐỔI MÔ HÌNH TIẾP THEO?

Những con ngựa không thể phát minh ra xe hơi.

Nhưng các nhà phát triển đã phát minh ra AI.

Nếu chúng ta ngừng suy nghĩ công khai về các vấn đề khó (thiết kế hệ thống, kiến trúc tổ chức, mô hình mở rộng), liệu AI thậm chí có dữ liệu để thực hiện bước nhảy vọt tiếp theo không?

Hay chúng ta chạm trần, nơi AI có thể duy trì các mô hình hiện có nhưng không thể phát minh ra cái mới?

Tôi không biết.

Nhưng “chúng ta là những con ngựa” là cách đặt vấn đề bất an nhất mà tôi từng nghe.

Điều Chúng Ta Thực Sự Cần

Tôi không có câu trả lời rõ ràng.

Nhưng đây là những câu hỏi đáng đặt ra:

Chúng ta có thể xây dựng Stack Overflow cho thời đại AI không?

Troels đã hỏi :

“Có lẽ ‘Stack Overflow cho thời đại AI’ tiếp theo của chúng ta vẫn chưa xuất hiện.

Có lẽ nó sẽ thậm chí còn tốt hơn cho chúng ta.”

Tôi thực sự hy vọng như vậy.

Nhưng nó thậm chí sẽ trông như thế nào?

Từ Stack Overflow (phần tốt):

- Công khai mặc định

- Sự tuyển chọn cộng đồng (bình chọn, câu trả lời được chấp nhận)

- Có thể tìm kiếm và khám phá

- Phát triển khi các framework thay đổi

Từ các cuộc trò chuyện AI (phần tốt):

- Giải thích kiên nhẫn

- Thích ứng với ngữ cảnh của bạn

- Đối thoại lặp đi lặp lại

- Không phán xét khi hỏi những câu “ngớ ngẩn”

Điều nó không thể là:

- Chỉ là nhật ký trò chuyện AI (quá ồn ào)

- Chỉ là câu trả lời AI được tuyển chọn (mất đi lý luận)

- Chỉ là tài liệu (mất đi cuộc trò chuyện)

Có lẽ nó giống như:

AI giúp bạn giải quyết vấn đề, sau đó bạn xuất bảncon đường lý luận

– không chỉ giải pháp

– trong một không gian có thể tìm kiếm, được cộng đồng tuyển chọn.

Cuộc trò chuyện lộn xộn của bạn trở thành tài liệu sạch sẽ.

Việc học tập riêng tư của bạn trở thành kiến thức công cộng.

Chúng ta có nên coi các cuộc trò chuyện AI như tạo tác không?

Khi bạn giải quyết điều gì đó mới mẻ với AI, bạn có nên công bố cuộc trò chuyện đó không?

Tạo ra không gian công cộng mới cho kiến thức thời đại AI?

Tìm một cơ chế tuyển chọn thực sự hiệu quả?

Pascal đề xuất:

“Sử dụng các câu trả lời chắc chắn mà chúng ta nhận được từ AI để xây dựng các wiki sạch sẽ, hữu ích, có lợi cho cả chúng ta và các hệ thống AI tương lai.”

Đây có thể là hướng đi.

Không từ bỏ AI, mà tạo ra các vòng phản hồi từ các cuộc trò chuyện AI riêng tư trở lại các cơ sở kiến thức công cộng.

Làm thế nào để chúng ta dạy kỹ năng chất vấn như một kỹ năng cốt lõi?

Biến “nghi ngờ AI” thành một phần rõ ràng trong cách chúng ta dạy phát triển.

Xây dựng sự hoài nghi vào quy trình làm việc.

Ngừng coi sự tự tin của AI là tính đúng đắn.

Như Ben đã nói:

“Con người phải luôn ở trong vòng lặp

– luôn luôn và mãi mãi.”

Sự thật Khó chịu

Chúng ta không chỉ đang thay đổi cách chúng ta viết mã.

Chúng ta đang thay đổi cách kiến thức được tích lũy.

Stack Overflow thật phiền phức.

Sự bảo thủ là có thật.

Văn hóa “đánh dấu là trùng lặp” thật thù địch.

Như Vinicius đã nắm bắt hoàn hảo :

“Tôi bắt đầu học Linux vào năm 2012.

Đôi khi tôi tìm thấy câu trả lời trên Stack Overflow.

Đôi khi tôi bị tấn công vì cách tôi đặt câu hỏi.

Giờ tôi hỏi Claude và nhận được lời giải thích rõ ràng, kiên nhẫn.

Những cộng đồng đã bảo vệ kiến thức cuối cùng lại huấn luyện các công cụ giờ đây cho nó đi miễn phí.”

Các chuyên gia thù địch đã tạo ra tập dữ liệu cho những cỗ máy kiên nhẫn.

Nhưng Stack Overflow là CÔNG KHAI.

Có thể tìm kiếm.

Có thể phát triển.

Các nhà phát triển tương lai có thể học từ những khó khăn của chúng ta.

Giờ tất cả chúng ta đang có cùng những cuộc trò chuyện trong riêng tư.

Giải quyết cùng những vấn đề một cách độc lập.

Xây dựng tốc độ cá nhân với cái giá là ký ức tập thể.

Sophia Devy đã nói hay nhất :

“Chúng ta đang giữa cuộc chuyển đổi mô hình và vẫn chưa có ngôn ngữ cho nó.”

Đó chính xác là nơi chúng ta đang đứng.

Ở đâu đó giữa cách cũ đang chết và cách mới đang nổi lên.

Chúng ta không biết đây là tiến bộ hay chỉ là…

sự thay đổi.

Nhưng quỹ đạo hiện tại không hoạt động về lâu dài.

Nếu kiến thức vẫn ở chế độ riêng tư, sự hiểu biết sẽ ngừng tích lũy.

Và nếu sự hiểu biết ngừng tích lũy, chúng ta không còn xây dựng dựa trên nhau nữa.

Chúng ta chỉ đang…

xử lý song song.

Cảm ơn rất nhiều đến tất cả những người đã bình luận về bài viết trước của tôi .

Bài viết này về cơ bản là một sự tổng hợp những hiểu biết của các bạn.

Đặc biệt cảm ơn Vinicius , Ben , Ingo , Amir , PEACEBINFLOW , Pascal , Mike , Troels , Sophia , Ali , Maame , webketje , doogal và Peter vì đã mài sắc tư duy này.

Quan điểm của bạn là gì?

Chúng ta đang hướng tới sự sụp đổ kiến thức, hay tôi đang suy nghĩ quá mức?

Hãy để lại bình luận

– hãy tiếp tục xây dựng sự hiểu biết một cách công khai.

![[Tự học C++] Số dấu phẩy động(float, double,…) trong C++](https://cafedev.vn/wp-content/uploads/2019/12/cafedevn_c_develoment-100x70.jpg)